苹果AR/VR专利提出图像数据+超声数据的混合注视追踪方法

同时使用图像数据和超声数据的混合注视追踪方法

(映维网Nweon 2024年10月28日)AR/VR头显越来越多地使用眼动追踪系统来追踪用户眼睛的位置和/或运动。所以,厂商正积极探索优化眼动追踪精度,稳定性和功耗的方法。

在一份专利申请中,苹果就提出了同时使用图像数据和超声数据的混合注视追踪方法。这家公司指出,以各种组合方式使用超声数据和成像数据的注视追踪可实现较低的功耗率,并且同时使用成像数据和超声数据的注视追踪比单独使用任何一种方法都更稳健,因为成像数据受温度、压力和气流的影响较小,而超声数据受杂散光的影响较小。

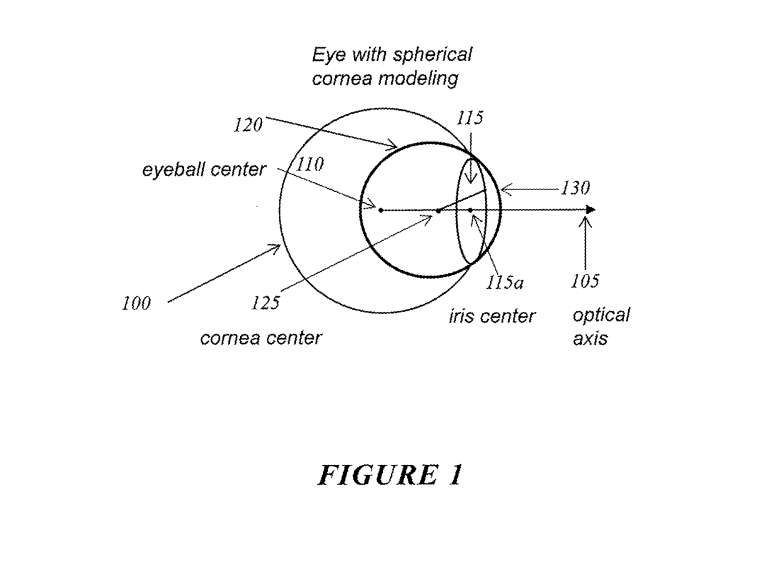

图1是描述眼球的3D表示,可以为每个用户独立地或唯一地生成眼睛100的眼球模型。

在一个实施例中,可以识别光轴105并用作眼睛100注视方向的指示。视轴是用户感知到的实际注视方向,并且与光轴105具有角偏移。视轴和光轴105之间的角偏移量因人而异。

在一个实施例中,估计眼睛的注视方向是基于确定光轴的两个位置。可以确定虹膜中心115a的3D空间位置和角膜中心125的3D空间位置作为光轴105的两个位置。另外,可以确定眼球旋转中心110的3D空间位置和角膜中心125的3D空间位置作为光轴105上的两个位置。这两个位置可以基于来自设备各种传感器的信息来确定。

......(全文 2870 字,剩余 2409 字)

注册用户请登入后阅读完整文章

映维会员、PICO员工可联系映维免费获取权限